단 3줄의 코드로 GPU 클라우드로부터 자유로워지세요.

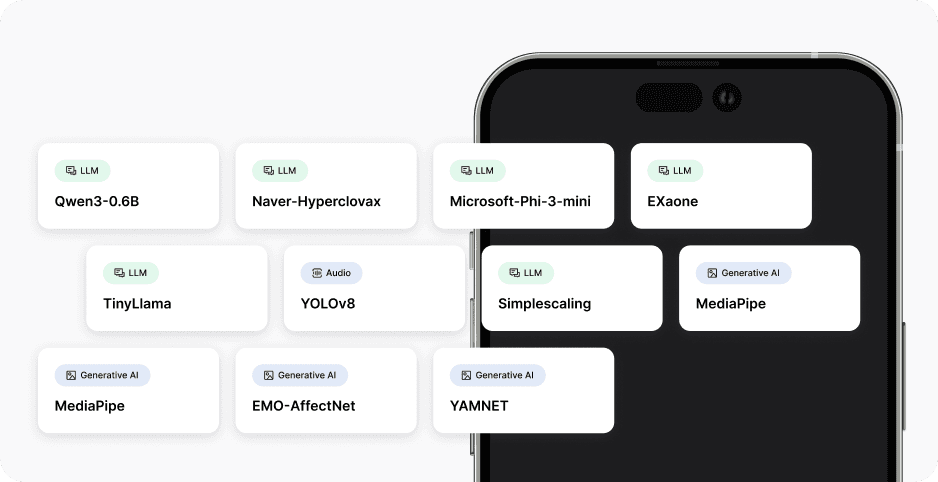

다양한 NPU나 OS에 동시에 적용할 수 있습니다.

ZETIC.ai (제틱에이아이)는 NPU 기반 온디바이스 AI 솔루션으로 AI 기업들의 문제를 해결하고,

가장 빠른 전환과 뛰어난 실행 성능을 제공합니다.

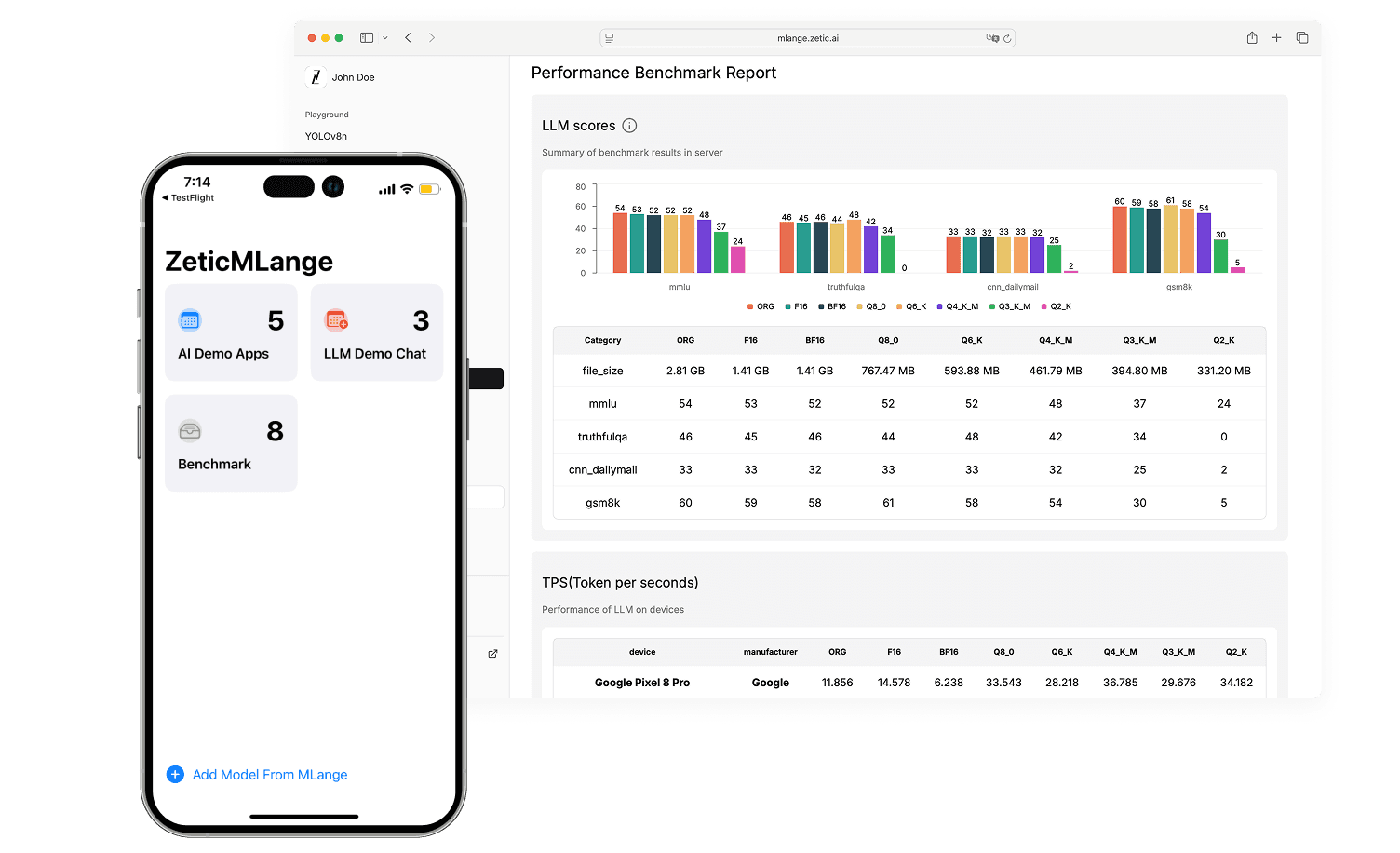

ZETIC.MLange

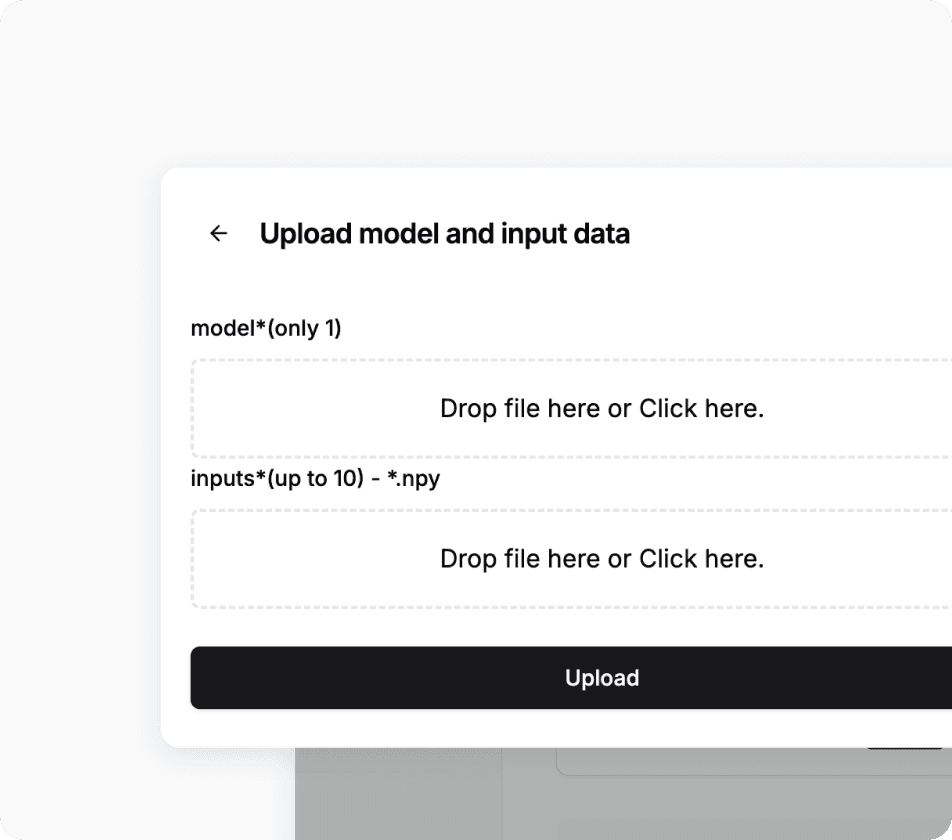

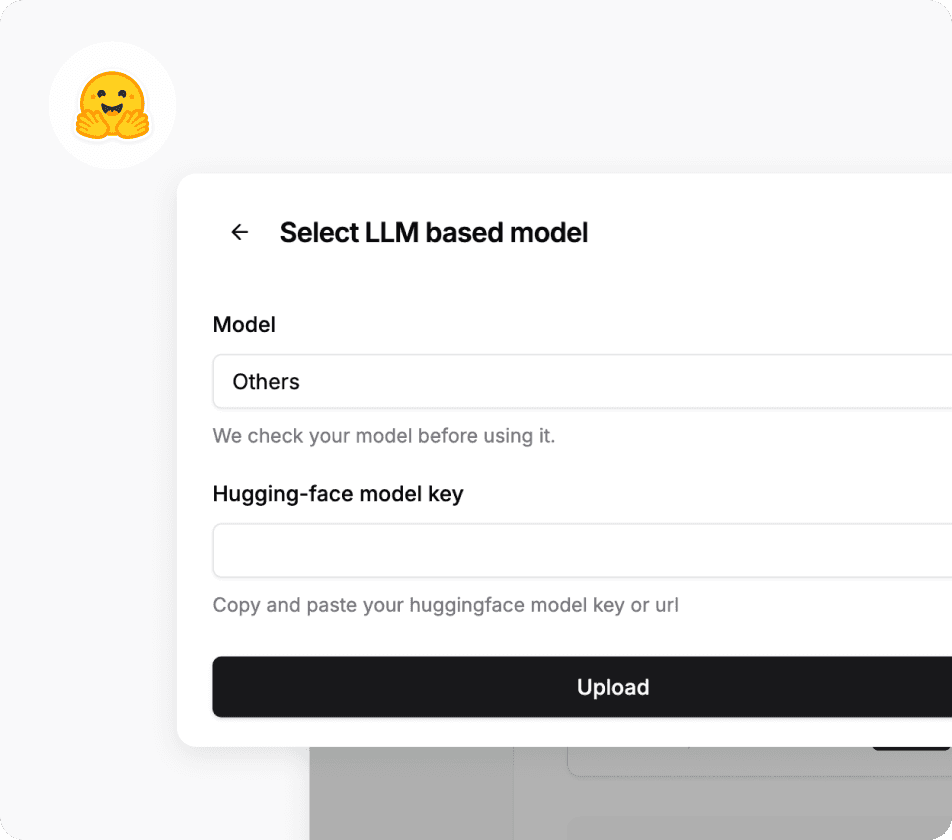

자동화된 파이프라인으로 손쉽게 AI 모델을 변환하고, 타겟 하드웨어에서 실행하여 막대한 GPU 서버 비용을 절감하고 보안을 강화하세요.

서버리스 AI로의 전환을 통해 GPU 클라우드 서버의 막대한 비용을 절감합니다.

NPU 활용을 극대화하여 정확도 손실 없이 빠른 실행 성능을 달성합니다.

ZETIC.ai의 완전히 자동화된 파이프라인은 온디바이스 AI 전환을 단 24시간 내에 완료합니다.

지금 바로 시작하세요.

서버 비용을 절감하고, 스마트폰에서 AI를 실행하세요.